人工智能技术以前所未有的速度发展,已深度融入医疗、金融、交通、教育等关键领域。随着AI应用软件开发的快速推进,安全问题日益凸显,成为制约人工智能健康发展的关键因素。

在AI应用开发过程中,数据安全始终是首要考量。训练数据的质量与安全性直接影响模型性能,若数据存在偏见或遭受污染,将导致决策偏差,在医疗诊断、信贷审批等场景可能造成严重后果。开发者必须建立严格的数据治理体系,确保数据采集、标注、存储全流程安全可控。

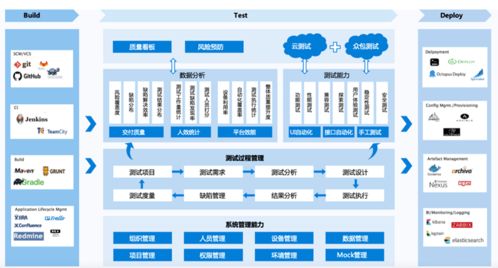

算法安全同样不容忽视。对抗性攻击可能通过微小扰动欺骗AI系统,自动驾驶中的交通标志识别、人脸认证系统都曾因此暴露出安全隐患。开发团队需要将安全测试贯穿整个开发生命周期,采用对抗训练、形式化验证等方法提升模型鲁棒性。

隐私保护是AI应用必须跨越的另一道门槛。联邦学习、差分隐私等技术创新让用户数据"可用不可见"正在成为行业标准。开发者在设计架构时,就应将隐私保护作为核心要素,而非事后补救。

AI系统的透明度和可解释性也关系到应用安全。在关键决策场景,黑箱模型可能带来不可预知的风险。通过开发可解释AI技术,建立算法审计机制,才能增强用户信任,促进负责任的人工智能发展。

人工智能的安全发展需要多方协同:技术团队需将安全理念融入开发基因,行业组织应加快安全标准制定,监管机构要完善法律法规。只有在安全基石上构建的人工智能应用,才能真正赋能各行各业,推动社会进步。